OpenAI, компанията зад ChatGPT, представи своя нов инструмент за текст към видео, захранван от изкуствен интелект. Това е напредък – но това може да не е непременно нещо добро.

Програмата, наречена Sora, все още не е публично достъпна, но примерните видеоклипове, споделени от компанията и нейния изпълнителен директор Сам Алтман, са просто умопомрачителни.

Вълнести мамути дефилират към „камерата“, оставяйки облаци от прахообразен сняг след себе си.

Снежинки се носят от небето, докато двойка се разхожда ръка за ръка през Токио.

Introducing Sora, our text-to-video model.

— OpenAI (@OpenAI) February 15, 2024

Sora can create videos of up to 60 seconds featuring highly detailed scenes, complex camera motion, and multiple characters with vibrant emotions. https://t.co/7j2JN27M3W

Prompt: “Beautiful, snowy… pic.twitter.com/ruTEWn87vf

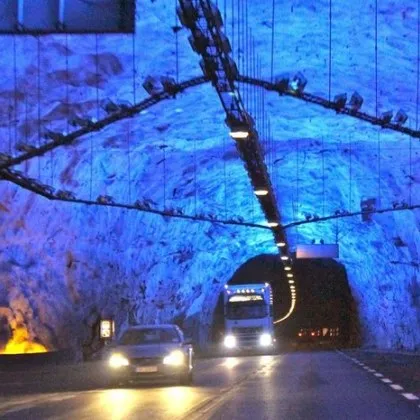

„Дрон“ преминава през познатите бели и сини сгради на Санторини привечер. На пръв поглед всичко е наред и това лесно може да е наистина кадър – без изчезналите животни. Всички са генерирани от прости команди и фирмата казва, че не са били редактирани по никакъв начин.

При по-внимателно разглеждане обаче повечето видеоклипове имат няколко издайнически подаръка.

Трио вълчета, играещи на чакълена писта, се умножава, докато се търкалят наоколо, спонтанно се появяват нови малки, които след това се сливат обратно в своите братя и сестри.

И точно както генеративният AI се е борил с цифри и крайници в миналото, същото е вярно – вероятно още повече – във видео формат. Пляскаща ръка расте и губи пръсти. Жена, лежаща в леглото, се слива с нейната завивка, която сякаш се превръща в ръката й.

Повечето хора изглежда ходят така, сякаш са претърпели лек инцидент.

Самият OpenAI знае, че все още не е съвършен.

Настоящият модел има слабости“, се казва на неговия уебсайт. „Може да има проблеми с точното симулиране на физиката на сложна сцена и може да не разбира конкретни случаи на причина и следствие.

„Например, човек може да отхапе бисквитка, но след това бисквитката може да няма следа от ухапване.“

Но това е първо поколение и е плашещо добро.

В една година с около 60 избори по целия свят и нарастваща загриженост всеки ден относно опасностите от дълбоки фалшификати, идеята, че създаването на такива реалистични видеоклипове скоро ще бъде в ръцете на всеки, който има интернет, ще изостри страховете от манипулиране на избирателите.

OpenAI обеща, че се отнася сериозно към безопасността, като се стреми да гарантира, че съдържанието, генерирано от AI, е маркирано и да спре използването му за злонамерени цели.

Но като се има предвид, че друг подобен софтуер вече е бил използван за създаване на изрично видео и за измама на президента на САЩ, спирането на хората, използващи AI, за да разстройват и смущават, е по-лесно да се каже, отколкото да се направи.

„Ще предприемем няколко важни стъпки за безопасност, преди да направим Sora достъпна в продуктите на OpenAI“, казаха от компанията. „Ние работим с червени екипи – експерти по домейни в области като дезинформация, насаждащо омраза съдържание и пристрастия – които ще тестват модела със съперничество.

„Ние също изграждаме инструменти, които да помогнат за откриването на подвеждащо съдържание, като например класификатор за откриване, който може да разбере кога видеоклипът е генериран от Sora.“

Въпреки уверенията им обаче, мнозина са обезпокоени от този гигантски скок напред в способностите.

Прочетете още

- 17:43 Напрежение в Буковлък: роми с палки и лопати, полицията затвори входовете и изходите ВИДЕО

- 20:29 Общинари с остри въпроси за „Колежа": кой прибира парите от паркинга и защо клубът раздава помещения?

- 17:00 След кетчупа и майонезата: Откраднаха чеснов сос от заведение за бързо хранене ВИДЕО

- 20:01 Арестуваха трима автокрадци във Волуяк, откраднали скъп джип, ето кои са СНИМКИ