–Δ–Ψ–≤–Α –Β –Ω―Ä–Ψ–¥―ä–Μ–Ε–Β–Ϋ–Η–Β –Ϋ–Α –Φ–Ψ―è―²–Α –Ω―ä―Ä–≤–Α―²–Α ―¹―²–Α―²–Η―è –Ζ–Α LPCNet. –£ –Ω―ä―Ä–≤–Ψ―²–Ψ –¥–Β–Φ–Ψ –Ϋ–Η–Β –Ω―Ä–Β–¥―¹―²–Α–≤–Η―Ö–Φ–Β –Α―Ä―Ö–Η―²–Β–Κ―²―É―Ä–Α, ―¹―ä―΅–Β―²–Α–≤–Α―â–Α –Ψ–±―Ä–Α–±–Ψ―²–Κ–Α –Ϋ–Α ―¹–Η–≥–Ϋ–Α–Μ–Η―²–Β –Η –¥―ä–Μ–±–Ψ–Κ–Ψ –Φ–Α―à–Η–Ϋ–Ϋ–Ψ –Ψ–±―É―΅–Β–Ϋ–Η–Β –Ζ–Α –Ω–Ψ–≤–Η―à–Α–≤–Α–Ϋ–Β –Β―³–Β–Κ―²–Η–≤–Ϋ–Ψ―¹―²―²–Α –Ϋ–Α ―¹–Η–Ϋ―²–Β–Ζ–Α –Ϋ–Α ―΅–Ψ–≤–Β―à–Κ–Α ―Ä–Β―΅ ―¹ –Ω–Ψ–Φ–Ψ―â―²–Α –Ϋ–Α –Ϋ–Β–≤―Ä–Ψ–Ϋ–Ϋ–Η –Φ―Ä–Β–Ε–Η. –Δ–Ψ–Ζ–Η –Ω―ä―² ―â–Β –Ω―Ä–Β–≤―ä―Ä–Ϋ–Β–Φ LPCNet –≤ –Ϋ–Β–≤―Ä–Ψ–Ϋ–Β–Ϋ ―Ä–Β―΅–Β–≤–Η –Κ–Ψ–¥–Β–Κ ―¹ –Φ–Ϋ–Ψ–≥–Ψ –Ϋ–Η―¹―ä–Κ –±–Η―²―Ä–Β–Ι―², –Κ–Ψ–Ι―²–Ψ –Φ–Ψ–Ε–Β –¥–Α ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α –≤ –¥–Ϋ–Β―à–Ϋ–Ψ―²–Ψ –Β–Μ–Β–Κ―²―Ä–Ψ–Ϋ–Ϋ–Ψ –Ψ–±–Ψ―Ä―É–¥–≤–Α–Ϋ–Β –Η –≤ ―²–Β–Μ–Β―³–Ψ–Ϋ–Η―²–Β.

–½–Α –Ω―ä―Ä–≤–Η –Ω―ä―² –Η–Φ–Α–Φ–Β ―¹–Μ―É―΅–Α–Ι, –≤ –Κ–Ψ–Ι―²–Ψ –Ϋ–Β–≤―Ä–Ψ–Ϋ–Β–Ϋ –≤–Ψ–Κ–Ψ–¥–Β―Ä ―Ä–Α–±–Ψ―²–Η –≤ ―Ä–Β–Α–Μ–Ϋ–Ψ –≤―Ä–Β–Φ–Β ―¹ –Ω–Ψ–Φ–Ψ―â―²–Α –Ϋ–Α ―¹–Α–Φ–Ψ –Β–¥–Ϋ–Ψ –Ω―Ä–Ψ―Ü–Β―¹–Ψ―Ä–Ϋ–Ψ ―è–¥―Ä–Ψ –Ϋ–Α ―¹–Φ–Α―Ä―²―³–Ψ–Ϋ–Α, –Α –Ϋ–Β ―΅―Ä–Β–Ζ –±―ä―Ä–Ζ –≥―Ä–Α―³–Η―΅–Β–Ϋ –Ω―Ä–Ψ―Ü–Β―¹–Ψ―Ä. –‰–Ζ–Ω–Ψ–Μ–Ζ–≤–Α ―¹–Β 1600 bit/s –±–Η―²―Ä–Β–Ι―², –Κ–Ψ–Β―²–Ψ –Β –Ψ–Κ–Ψ–Μ–Ψ 10 –Ω―ä―²–Η –Ω–Ψ-–Φ–Α–Μ–Κ–Ψ –≤ ―¹―Ä–Α–≤–Ϋ–Β–Ϋ–Η–Β ―¹―ä―¹ ―¹–Β–≥–Α ―¹―ä―â–Β―¹―²–≤―É–≤–Α―â–Η―²–Β ―à–Η―Ä–Ψ–Κ–Ψ–Μ–Β–Ϋ―²–Ψ–≤–Η –Κ–Ψ–¥–Β―Ü–Η. –ù–Ψ –Κ–Α―΅–Β―¹―²–≤–Ψ―²–Ψ –Β –Φ–Ϋ–Ψ–≥–Ψ –Ω–Ψ-–¥–Ψ–±―Ä–Ψ –Ψ―² ―²–Ψ–≤–Α –Ϋ–Α –¥–Ϋ–Β―à–Ϋ–Η―²–Β –Κ–Ψ–¥–Β―Ü–Η ―¹ –Φ–Ϋ–Ψ–≥–Ψ –Ϋ–Η―¹―ä–Κ –±–Η―²―Ä–Β–Ι―² –Η –Β ―¹―ä–Ω–Ψ―¹―²–Α–≤–Η–Φ–Ψ ―¹ ―²―Ä–Α–¥–Η―Ü–Η–Ψ–Ϋ–Ϋ–Η―²–Β –Κ–Ψ–¥–Β―Ü–Η, –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α―â–Η –Ω–Ψ-–≤–Η―¹–Ψ–Κ –±–Η―²―Ä–Β–Ι―².

–ö–Ψ–¥–Β―Ü–Η –Ζ–Α ―³–Ψ―Ä–Φ–Α―²–Α –Ϋ–Α ―¹–Η–≥–Ϋ–Α–Μ–Α –Η –≤–Ψ–Κ–Ψ–¥–Β―Ä–Η –Ω―Ä–Η ―¹–Η–Ϋ―²–Β–Ζ–Η―Ä–Α–Ϋ–Β―²–Ψ –Ϋ–Α ―΅–Ψ–≤–Β―à–Κ–Α ―Ä–Β―΅

–‰–Φ–Α –¥–≤–Α ―²–Η–Ω–Α ―Ä–Β―΅–Β–≤–Η –Κ–Ψ–¥–Β―Ü–Η. –Δ–Ψ–≤–Α ―¹–Α –Κ–Ψ–¥–Β―Ü–Η―²–Β ―¹ –Ω―Ä–Ψ–Φ–Β–Ϋ–Μ–Η–≤–Α ―³–Ψ―Ä–Φ–Α –Ϋ–Α ―¹–Η–≥–Ϋ–Α–Μ–Α (waveform coder) –Η –≤–Ψ–Κ–Ψ–¥–Β―Ä–Η―²–Β. –ü―ä―Ä–≤–Η―²–Β –≤–Κ–Μ―é―΅–≤–Α―² Opus, AMR/AMR-WB –Η –≤―¹–Η―΅–Κ–Η –Κ–Ψ–¥–Β―Ü–Η, –Κ–Ψ–Η―²–Ψ ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α―² –≤ –Φ―É–Ζ–Η–Κ–Α―²–Α. –Δ–Β ―¹–Β –Ψ–Ω–Η―²–≤–Α―² –¥–Α –Ψ―¹–Η–≥―É―Ä―è―² –¥–Β–Κ–Ψ–¥–Η―Ä–Α–Ϋ–Β―²–Ψ –Ϋ–Α ―³–Ψ―Ä–Φ–Α―²–Α –Ϋ–Α ―¹–Η–≥–Ϋ–Α–Μ–Α –¥–Α –±―ä–¥–Β –≤―ä–Ζ–Φ–Ψ–Ε–Ϋ–Ψ –Ϋ–Α–Ι-–±–Μ–Η–Ζ–Κ–Α –¥–Ψ –Ψ―Ä–Η–≥–Η–Ϋ–Α–Μ–Α, –Κ–Α―²–Ψ ―¹–Β –≤–Ζ–Β–Φ–Α―² –Ω―Ä–Β–¥–≤–Η–¥ –Ϋ―è–Κ–Ψ–Η –Ω–Β―Ä―Ü–Β–Ω―²–Η–≤–Ϋ–Η –Ψ―¹–Ψ–±–Β–Ϋ–Ψ―¹―²–Η. –û―² –¥―Ä―É–≥–Α ―¹―²―Ä–Α–Ϋ–Α, –Ζ–Α –≤–Ψ–Κ–Ψ–¥–Β―Ä–Η―²–Β –Φ–Ψ–Ε–Β –¥–Α ―¹–Β –Κ–Α–Ε–Β, ―΅–Β –Ϋ–Α–Η―¹―²–Η–Ϋ–Α ―¹–Α ―¹–Η–Ϋ―²–Β–Ζ–Α―²–Ψ―Ä–Η. –ü―Ä–Β–¥–≤–Α―Ä–Η―²–Β–Μ–Ϋ–Ψ ―¹–Β –Η–Ζ–≤–Μ–Η―΅–Α –Η–Ϋ―³–Ψ―Ä–Φ–Α―Ü–Η―è―²–Α –Ζ–Α –≤–Η―¹–Ψ―΅–Η–Ϋ–Α―²–Α –Ϋ–Α –Ζ–≤―É–Κ–Α –Η ―³–Ψ―Ä–Φ–Α―²–Α –Ϋ–Α –≤–Ψ–Κ–Α–Μ–Ϋ–Η―è ―²―Ä–Α–Κ―², ―¹–Μ–Β–¥ –Κ–Ψ–Β―²–Ψ ―²–Β–Ζ–Η –¥–Α–Ϋ–Ϋ–Η ―¹–Β –Ω–Ψ–¥–Α–≤–Α―² –Ϋ–Α –¥–Β–Κ–Ψ–¥–Β―Ä–Α, –Κ–Ψ–Ι―²–Ψ –Ψ―²–Ϋ–Ψ–≤–Ψ ―¹–Η–Ϋ―²–Β–Ζ–Η―Ä–Α ―Ä–Β―΅―²–Α. –Δ–Ψ–≤–Α –Β –Ω–Ψ―΅―²–Η –Κ–Α―²–Ψ ―Ä–Α–Ζ–Ω–Ψ–Ζ–Ϋ–Α–≤–Α–Ϋ–Β –Ϋ–Α ―Ä–Β―΅, ―¹–Μ–Β–¥–≤–Α–Ϋ–Ψ –Ψ―² ―΅–Β―²–Β–Ϋ–Β―²–Ψ –Ϋ–Α ―²–Ψ–Ζ–Η ―²–Β–Κ―¹―². –Γ–Α–Φ–Ψ ―΅–Β –≤―¹–Η―΅–Κ–Ψ –Β ―¹―ä–≤―¹–Β–Φ –Ψ–Ω―Ä–Ψ―¹―²–Β–Ϋ–Ψ –Η ―Ä–Α–±–Ψ―²–Η –±―ä―Ä–Ζ–Ψ, –≤ ―¹―Ä–Α–≤–Ϋ–Β–Ϋ–Η–Β ―¹ –Κ–Ψ–Φ–Ω―é―²―ä―Ä–Ϋ–Ψ―²–Ψ ―Ä–Α–Ζ–Ω–Ψ–Ζ–Ϋ–Α–≤–Α–Ϋ–Β –Ϋ–Α ―Ä–Β―΅―²–Α.

–£–Ψ–Κ–Ψ–¥–Β―Ä–Η―²–Β ―¹–Α –Ω–Ψ–Ζ–Ϋ–Α―²–Η –Ψ―â–Β –Ψ―² 70-―²–Β –≥–Ψ–¥–Η–Ϋ–Η, –Ϋ–Ψ –Ω–Ψ–Ϋ–Β–Ε–Β ―²–Β―Ö–Ϋ–Η―²–Β –¥–Β–Κ–Ψ–¥–Β―Ä–Η ―¹–Β –Ψ–Ω–Η―²–≤–Α―² –¥–Α ―¹–Η–Ϋ―²–Β–Ζ–Η―Ä–Α―² ―Ä–Β―΅―²–Α, ―²–Β –Ϋ―è–Φ–Α –Κ–Α–Κ –¥–Α –±―ä–¥–Α―² –Ω–Ψ-–¥–Ψ–±―Ä–Η –Ψ―² ―¹―²–Α–Ϋ–¥–Α―Ä―²–Ϋ–Η―²–Β ―¹–Η―¹―²–Β–Φ–Η –Ζ–Α ―¹–Η–Ϋ―²–Β–Ζ –Ϋ–Α ―΅–Ψ–≤–Β―à–Κ–Α ―Ä–Β―΅, –Κ–Ψ–Η―²–Ψ ―¹―ä–≤―¹–Β–Φ –¥–Ψ―¹–Κ–Ψ―Ä–Ψ –Ζ–≤―É―΅–Α―Ö–Α –Ϋ–Α–Ω―Ä–Α–≤–Ψ ―É–Ε–Α―¹–Ϋ–Ψ. –ï―²–Ψ –Ζ–Α―â–Ψ –≤–Ψ–Κ–Ψ–¥–Β―Ä–Η―²–Β –Ψ–±–Η–Κ–Ϋ–Ψ–≤–Β–Ϋ–Ψ ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α―² –Ω―Ä–Η ―¹–Κ–Ψ―Ä–Ψ―¹―²–Η –Ω–Ψ–¥ 3 KB/s. –£―¹–Η―΅–Κ–Ψ ―²–Ψ–≤–Α –Ω―Ä–Ψ–¥―ä–Μ–Ε–Η, –¥–Ψ–Κ–Α―²–Ψ –Ϋ–Β ―¹–Β –Ω–Ψ―è–≤–Η―Ö–Α –Ϋ–Β–≤―Ä–Ψ–Ϋ–Ϋ–Η―²–Β ―¹–Η―¹―²–Β–Φ–Η –Ζ–Α ―¹–Η–Ϋ―²–Β–Ζ –Ϋ–Α ―΅–Ψ–≤–Β―à–Κ–Α ―Ä–Β―΅, –Κ–Α―²–Ψ –Ϋ–Α–Ω―Ä–Η–Φ–Β―Ä WaveNet. –Γ–Η–Ϋ―²–Β–Ζ―ä―² –Ϋ–Α ―Ä–Β―΅ –Η–Ζ–≤–Β–¥–Ϋ―ä–Ε –Ζ–Α–Ω–Ψ―΅–Ϋ–Α –¥–Α –Ζ–≤―É―΅–Η –Φ–Ϋ–Ψ–≥–Ψ –Ω–Ψ-–¥–Ψ–±―Ä–Β, –Φ–Ψ–Ε–Β –¥–Α ―¹–Β –Κ–Α–Ε–Β –¥–Ψ―Ä–Η –Ω–Β―Ä―³–Β–Κ―²–Ϋ–Ψ, –Η ―Ä–Α–Ζ–±–Η―Ä–Α ―¹–Β, –Ω–Ψ―è–≤–Η―Ö–Α ―¹–Β –Φ–Ϋ–Ψ–≥–Ψ –Ε–Β–Μ–Α–Β―â–Η –¥–Α ―¹–Η –Ϋ–Α–Ω―Ä–Α–≤―è―² –≤–Ψ–Κ–Ψ–¥–Β―Ä –Κ–Α―²–Ψ WaveNet.

–ö–Α–Κ–≤–Ψ –Β LPCNet

WaveNet –¥–Α–≤–Α –Φ–Ϋ–Ψ–≥–Ψ –Κ–Α―΅–Β―¹―²–≤–Β–Ϋ–Α ―Ä–Β―΅, –Ϋ–Ψ –Η―¹–Κ–Α ―¹―²–Ψ―²–Η―Ü–Η –≥–Η–≥–Α―³–Μ–Ψ–Ω―¹–Η –Η–Ζ―΅–Η―¹–Μ–Η―²–Β–Μ–Ϋ–Α –Φ–Ψ―â–Ϋ–Ψ―¹―². LPCNet –Ζ–Ϋ–Α―΅–Η―²–Β–Μ–Ϋ–Ψ –Ϋ–Α–Φ–Α–Μ–Η ―¹–Μ–Ψ–Ε–Ϋ–Ψ―¹―²―²–Α –Ϋ–Α –Η–Ζ―΅–Η―¹–Μ–Β–Ϋ–Η―è―²–Α. –£–Ψ–Κ–Ψ–¥–Β―Ä―ä―² ―¹–Β –±–Α–Ζ–Η―Ä–Α –Ϋ–Α WaveRNN, –Κ–Ψ―è―²–Ψ –Ω–Ψ–¥–Ψ–±―Ä―è–≤–Α WaveNet ―¹ –Ω–Ψ–Φ–Ψ―â―²–Α –Ϋ–Α ―Ä–Β–Κ―É―Ä–Β–Ϋ―²–Ϋ–Α –Ϋ–Β–≤―Ä–Ψ–Ϋ–Ϋ–Α –Φ―Ä–Β–Ε–Α (RNN) –Η ―Ä–Α–Ζ―Ä–Β–¥–Β–Ϋ–Η –Φ–Α―²―Ä–Η―Ü–Η. LPCNet –¥–Ψ–Ω―ä–Μ–Ϋ–Η―²–Β–Μ–Ϋ–Ψ –Ω–Ψ–¥–Ψ–±―Ä―è–≤–Α WaveRNN ―¹ –Ω–Ψ–Φ–Ψ―â―²–Α –Ϋ–Α –Μ–Η–Ϋ–Β–Ι–Ϋ–Ψ –Ω―Ä–Β–¥―¹–Κ–Α–Ζ–≤–Α–Ϋ–Β (LPC), –Κ–Ψ–Β―²–Ψ ―¹–Β –Ω―Ä–Β–¥―¹―²–Α–≤―è –¥–Ψ–±―Ä–Β –≤ ―¹―²–Α―Ä–Η―²–Β –≤–Ψ–Κ–Ψ–¥–Β―Ä–Η. –Δ–Ψ –Ω―Ä–Β–¥―¹–Κ–Α–Ζ–≤–Α –Α―É–¥–Η–Ψ-―¹–Β–Φ–Ω―ä–Μ –Ω–Ψ –Μ–Η–Ϋ–Β–Ι–Ϋ–Α―²–Α –Κ–Ψ–Φ–±–Η–Ϋ–Α―Ü–Η―è –Ϋ–Α –Ω―Ä–Β–¥–Η―à–Ϋ–Η―²–Β ―¹–Β–Φ–Ω–Μ–Η –Η –Κ–Ψ–Β―²–Ψ –Β –Ϋ–Α–Ι-–≥–Μ–Α–≤–Ϋ–Ψ―²–Ψ, –Ω―Ä–Α–≤–Η –≤―¹–Η―΅–Κ–Ψ ―²–Ψ–≤–Α –Φ–Ϋ–Ψ–≥–Ψ–Κ―Ä–Α―²–Ϋ–Ψ –Ω–Ψ-–±―ä―Ä–Ζ–Ψ –Ψ―² –Ϋ–Β–≤―Ä–Ψ–Ϋ–Ϋ–Α―²–Α –Φ―Ä–Β–Ε–Α. –†–Α–Ζ–±–Η―Ä–Α ―¹–Β, ―²–Ψ–≤–Α –Ϋ–Β –Β ―É–Ϋ–Η–≤–Β―Ä―¹–Α–Μ–Β–Ϋ –Φ–Β―²–Ψ–¥ (–Η–Ϋ–Α―΅–Β –≤–Ψ–Κ–Ψ–¥–Β―Ä–Η―²–Β –Ψ―² 70-―²–Β –≥–Ψ–¥–Η–Ϋ–Η ―â―è―Ö–Α –¥–Α –Ζ–≤―É―΅–Α―² –Φ–Ϋ–Ψ–≥–Ψ –Ω–Ψ-–¥–Ψ–±―Ä–Β), –Ϋ–Ψ ―¹–Β―Ä–Η–Ψ–Ζ–Ϋ–Ψ –Ϋ–Α–Φ–Α–Μ―è–≤–Α –Ϋ–Α―²–Ψ–≤–Α―Ä–≤–Α–Ϋ–Β―²–Ψ –Ϋ–Α –Ϋ–Β–≤―Ä–Ψ–Ϋ–Ϋ–Α―²–Α –Φ―Ä–Β–Ε–Α. –ü–Ψ ―²–Ψ–Ζ–Η –Ϋ–Α―΅–Η–Ϋ ―¹―²–Α–≤–Α –≤―ä–Ζ–Φ–Ψ–Ε–Ϋ–Ψ –¥–Α ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α –Ϋ–Β–≤―Ä–Ψ–Ϋ–Ϋ–Α –Φ―Ä–Β–Ε–Α ―¹ –Φ–Ϋ–Ψ–≥–Ψ –Ω–Ψ-–Φ–Α–Μ―ä–Κ ―Ä–Α–Ζ–Φ–Β―Ä, –Ψ―²–Κ–Ψ–Μ–Κ–Ψ―²–Ψ WaveRNN, –±–Β–Ζ ―²–Ψ–≤–Α –¥–Α –Ψ–Κ–Α–Ε–Β –≤–Μ–Η―è–Ϋ–Η–Β –Ϋ–Α –Κ–Α―΅–Β―¹―²–≤–Ψ―²–Ψ.

–Ξ–Α―Ä–Α–Κ―²–Β―Ä–Η―¹―²–Η–Κ–Η –Ϋ–Α –Κ–Ψ–Φ–Ω―Ä–Β―¹–Η―è―²–Α

LPCNet ―¹–Η–Ϋ―²–Β–Ζ–Η―Ä–Α ―Ä–Β―΅―²–Α ―΅―Ä–Β–Ζ –≤–Β–Κ―²–Ψ―Ä –Ψ―² 20 –Ω―Ä–Η–Ζ–Ϋ–Α–Κ–Α –Ζ–Α –≤―¹–Β–Κ–Η ―³―Ä–Β–Ι–Φ –Ψ―² 10 –Φ–Η–Μ–Η―¹–Β–Κ―É–Ϋ–¥–Η. 18 –Ψ―² ―²―è―Ö ―¹–Α –Κ–Β–Ω―¹―²―Ä–Α–Μ–Ϋ–Η –Κ–Ψ–Β―³–Η―Ü–Η–Β–Ϋ―²–Η –Ζ–Α ―³–Ψ―Ä–Φ–Α―²–Α –Ϋ–Α ―¹–Ω–Β–Κ―²―ä―Ä–Α. –û―² –Ψ―¹―²–Α–Ϋ–Α–Μ–Η―²–Β –¥–≤–Α –Ω―Ä–Η–Ζ–Ϋ–Α–Κ–Α –Β–¥–Η–Ϋ–Η―è―² ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α –Ζ–Α ―¹―²―ä–Ω–Κ–Α―²–Α –Ϋ–Α –Ϋ–Η–≤–Ψ―²–Ψ (pitch period), –Α –¥―Ä―É–≥–Η―è―² –Β –Ζ–Α ―¹–Η–Μ–Α―²–Α (–¥–Ψ–Κ–Ψ–Μ–Κ–Ψ ―¹–Η–≥–Ϋ–Α–Μ―ä―² –Κ–Ψ―Ä–Β–Μ–Η―Ä–Α ―¹―ä―¹ ―¹–Β–±–Β ―¹–Η, –Α–Κ–Ψ ―¹–Β –≤―ä–≤–Β–¥–Β –Ζ–Α–±–Α–≤―è–Ϋ–Β –Ϋ–Α –Β–¥–Η–Ϋ pitch period). –ê–Κ–Ψ ―²–Β–Ζ–Η –Ω–Α―Ä–Α–Φ–Β―²―Ä–Η ―¹–Β ―¹―ä―Ö―Ä–Α–Ϋ―è–≤–Α―² –≤―ä–≤ –≤–Η–¥–Α –Ϋ–Α ―΅–Η―¹–Μ–Α ―¹ –Ω–Μ–Α–≤–Α―â–Α –Ζ–Α–Ω–Β―²–Α―è, ―²–Ψ ―Ü―è–Μ–Α―²–Α –Η–Ϋ―³–Ψ―Ä–Φ–Α―Ü–Η―è –Ζ–Α–Β–Φ–Α –¥–Ψ 64 kb/s –Ω―Ä–Η –Ζ–Α–Ω–Η―¹ –Ϋ–Α ―¹–Η–≥–Ϋ–Α–Μ–Α –Η–Μ–Η –Ω―Ä–Η –Ϋ–Β–≥–Ψ–≤–Ψ―²–Ψ –Ω―Ä–Β–¥–Α–≤–Α–Ϋ–Β. –Δ–Ψ–≤–Α –Β ―²–≤―ä―Ä–¥–Β –Φ–Ϋ–Ψ–≥–Ψ βÄ™ –¥–Ψ―Ä–Η Opus –Κ–Ψ–¥–Β–Κ–Α –Ψ―¹–Η–≥―É―Ä―è–≤–Α –Κ–Α―΅–Β―¹―²–≤–Β–Ϋ–Ψ –Κ–Ψ–¥–Η―Ä–Α–Ϋ–Β –Ϋ–Α ―Ä–Β―΅―²–Α ―¹–Α–Φ–Ψ –Ω―Ä–Η 16 kb/s (–Ζ–Α 16 KHz –Φ–Ψ–Ϋ–Ψ). –û―΅–Β–≤–Η–¥–Ϋ–Ψ –Β, ―΅–Β ―â–Β ―²―Ä―è–±–≤–Α –¥–Α ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α ―¹–Η–Μ–Ϋ–Α –Κ–Ψ–Φ–Ω―Ä–Β―¹–Η―è.

–£–Η―¹–Ψ―΅–Η–Ϋ–Α―²–Α

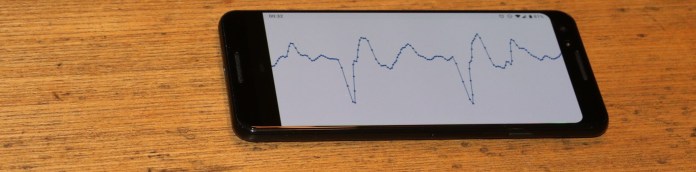

–£―¹–Η―΅–Κ–Η –Κ–Ψ–¥–Β―Ü–Η –≤ –Ζ–Ϋ–Α―΅–Η―²–Β–Μ–Ϋ–Α ―¹―²–Β–Ω–Β–Ϋ ―¹–Β –±–Α–Ζ–Η―Ä–Α―² –Ϋ–Α –≤–Η―¹–Ψ―΅–Η–Ϋ–Α―²–Α –Ϋ–Α ―²–Ψ–Ϋ–Α. –ê–Κ–Ψ –≤–Η―¹–Ψ―΅–Η–Ϋ–Α―²–Α –±―ä–¥–Β –Ω–Ψ–¥–±―Ä–Α–Ϋ–Α –Ϋ–Β–Ω―Ä–Α–≤–Η–Μ–Ϋ–Ψ, ―²–Ψ –Ζ–Α–Ω–Ψ―΅–≤–Α –¥–Α ―¹–Β –≥–Β–Ϋ–Β―Ä–Η―Ä–Α –Ζ–Μ–Β –Ζ–≤―É―΅–Α―â–Α ―Ä–Β―΅, –Κ–Ψ―è―²–Ψ ―΅–Β―¹―²–Ψ –Ω―ä―²–Η –Β –Ϋ–Β―Ä–Α–Ζ–±–Η―Ä–Α–Β–Φ–Α. –ë–Β–Ζ –¥–Α –Ϋ–Α–≤–Μ–Η–Ζ–Α–Φ–Β –≤ –Ω–Ψ–¥―Ä–Ψ–±–Ϋ–Ψ―¹―²–Η, –Β–Ϋ–Κ–Ψ–¥–Β―Ä―ä―² –Ϋ–Α LPCNet –Ϋ–Α–Ι-–≤–Ϋ–Η–Φ–Α―²–Β–Μ–Ϋ–Ψ ―¹–Β –Ψ–Ω–Η―²–≤–Α –¥–Α –Ϋ–Β ―¹–≥―Ä–Β―à–Η –Ω―Ä–Η –Ψ–Ω―Ä–Β–¥–Β–Μ―è–Ϋ–Β –Ϋ–Α –≤–Η―¹–Ψ―΅–Η–Ϋ–Α―²–Α. –Δ―ä―Ä―¹–Β–Ϋ–Β―²–Ψ –Ϋ–Α –Ϋ–Α–Ι-–Ω–Ψ–¥―Ö–Ψ–¥―è―â–Ψ―²–Ψ –Ζ–Ϋ–Α―΅–Β–Ϋ–Η–Β –Ζ–Α–Ω–Ψ―΅–≤–Α ―¹ ―²―ä―Ä―¹–Β–Ϋ–Β―²–Ψ –Ϋ–Α –Κ–Ψ―Ä–Β–Μ–Α―Ü–Η―è –Ω–Ψ –≤―Ä–Β–Φ–Β –≤ ―Ä–Β―΅–Β–≤–Η―è ―¹–Η–≥–Ϋ–Α–Μ. –ü–Ψ –¥–Ψ–Μ―É –Β –Ω–Ψ–Κ–Α–Ζ–Α–Ϋ–Ψ –Κ–Α–Κ ―Ä–Α–±–Ψ―²–Η ―²–Ψ–≤–Α ―²―ä―Ä―¹–Β–Ϋ–Β.

–Δ–Α–Ζ–Η –Η–Ϋ―³–Ψ―Ä–Φ–Α―Ü–Η―è ―²―Ä―è–±–≤–Α –¥–Α –±―ä–¥–Β –Κ–Ψ–¥–Η―Ä–Α–Ϋ–Α –≤―ä–≤ –≤―ä–Ζ–Φ–Ψ–Ε–Ϋ–Ψ –Ϋ–Α–Ι-–Φ–Α–Μ―ä–Κ –±―Ä–Ψ–Ι –±–Η―²–Ψ–≤–Β. –‰ –Ω–Ψ–Ϋ–Β–Ε–Β –Ϋ–Η–Β –Ω–Ψ –Ω―Ä–Η―Ä–Ψ–¥–Α –≤―ä–Ζ–Ω―Ä–Η–Β–Φ–Α–Φ–Β ―΅–Β―¹―²–Ψ―²–Α―²–Α –Ω–Ψ –Μ–Ψ–≥–Α―Ä–Η―²–Φ–Η―΅–Ϋ–Α ―¹–Κ–Α–Μ–Α, –Η–Φ–Α ―¹–Φ–Η―¹―ä–Μ –Ψ―² –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Ϋ–Β―²–Ψ –Ϋ–Α –Μ–Ψ–≥–Α―Ä–Η―²–Φ–Η―΅–Ϋ–Ψ –Κ–Ψ–¥–Η―Ä–Α–Ϋ–Β. –ù–Η–≤–Ψ―²–Ψ –Ϋ–Α ―Ä–Β―΅–Β–≤–Η―è ―¹–Η–≥–Ϋ–Α–Μ –Ω―Ä–Η –Ω–Ψ–≤–Β―΅–Β―²–Ψ ―Ö–Ψ―Ä–Α (–Ϋ―è–Φ–Α –¥–Α –Κ–Ψ–¥–Η―Ä–Α–Φ–Β ―¹–Ψ–Ω―Ä–Α–Ϋ–Ψ) –Β –≤ –¥–Η–Α–Ω–Α–Ζ–Ψ–Ϋ–Α –Ψ―² 62,5 –Η 500 Hz. –Γ―ä―¹ ―¹–Β–¥–Β–Φ –±–Η―²–Α (128 –Ζ–Ϋ–Α―΅–Β–Ϋ–Η―è) –Ϋ–Ψ–Ε–Β–Φ –¥–Α –Ω–Ψ–Μ―É―΅–Η–Φ ―Ä–Β–Ζ–Ψ–Μ―é―Ü–Η―è –Ψ―² ―΅–Β―²–≤―ä―Ä―² ―²–Ψ–Ϋ (―Ä–Α–Ζ–Μ–Η–Κ–Α―²–Α –Φ–Β–Ε–¥―É –Ϋ–Ψ―²–Η―²–Β –¥–Ψ –Η ―Ä–Β –Β –Β–¥–Η–Ϋ ―²–Ψ–Ϋ)

–ù–Ψ ―Ö–Ψ―Ä–Α―²–Α –Ϋ–Β –≥–Ψ–≤–Ψ―Ä―è―² –Κ–Α―²–Ψ ―Ä–Ψ–±–Ψ―²–Η –Ψ―² ―³–Η–Μ–Φ–Η―²–Β –Ψ―² 60-―²–Β –≥–Ψ–¥–Η–Ϋ–Η. –£–Η―¹–Ψ―΅–Η–Ϋ–Α―²–Α –Ϋ–Α ―΅–Ψ–≤–Β―à–Κ–Η―è –≥–Μ–Α―¹ –Φ–Ψ–Ε–Β –¥–Α ―¹–Β –Ω―Ä–Ψ–Φ–Β–Ϋ―è –¥–Ψ―Ä–Η –Η –≤ ―Ä–Α–Φ–Κ–Η―²–Β –Ϋ–Α –Β–¥–Η–Ϋ 40 ms –Ω–Α–Κ–Β―². –Δ–Ψ–≤–Α ―²―Ä―è–±–≤–Α –¥–Α ―¹–Β –Ψ―²―΅–Β―²–Β –Η –¥–Α ―¹–Β –Ψ―¹―²–Α–≤―è―² –±–Η―²–Ψ–≤–Β –Ζ–Α –Ω–Α―Ä–Α–Φ–Β―²―ä―Ä–Α –Ϋ–Α –Ω―Ä–Ψ–Φ―è–Ϋ–Α―²–Α –Ϋ–Α –≤–Η―¹–Ψ―΅–Η–Ϋ–Α―²–Α: 3 –±–Η―²–Α –Ζ–Α –Κ–Ψ–¥–Η―Ä–Α–Ϋ–Β –Ϋ–Α ―Ä–Α–Ζ–Μ–Η–Κ–Α―²–Α –¥–Ψ –¥–≤–Α –Ω–Ψ–Μ―É―²–Ψ–Ϋ–Α –Φ–Β–Ε–¥―É –Ϋ–Α―΅–Α–Μ–Ψ―²–Ψ –Η –Κ―Ä–Α―è –Ϋ–Α –Ω–Α–Κ–Β―²–Α. –‰ –Ϋ–Α–Κ―Ä–Α―è, –Ϋ–Β–Ψ–±―Ö–Ψ–¥–Η–Φ–Ψ –Β –¥–Α ―¹–Β –Κ–Ψ–¥–Η―Ä–Α –Κ–Ψ―Ä–Β–Μ–Α―Ü–Η―è―²–Α –Ϋ–Α –≤–Η―¹–Ψ―΅–Η–Ϋ–Α―²–Α –Ϋ–Α ―²–Ψ–Ϋ–Ψ–≤–Β―²–Β, –Ζ–Α –¥–Α –Φ–Ψ–Ε–Β–Φ –¥–Α ―Ä–Α–Ζ–Μ–Η―΅–Α–≤–Α–Φ–Β –≥–Μ–Α―¹–Ϋ–Η―²–Β –Η ―¹―ä–≥–Μ–Α―¹–Ϋ–Η―²–Β. –½–Α ―²–Α–Ζ–Η –Κ–Ψ―Ä–Β–Μ–Α―Ü–Η―è ―¹–Α –¥–Ψ―¹―²–Α―²―ä―΅–Ϋ–Η –¥–≤–Α –±–Η―²–Α.

–ö–Β–Ω―¹―²―ä―Ä

–î–Ψ–Κ–Α―²–Ψ –Ϋ–Η–≤–Α―²–Α ―¹―ä–¥―ä―Ä–Ε–Α―² –≤―ä–Ϋ―à–Ϋ–Η―²–Β ―Ö–Α―Ä–Α–Κ―²–Β―Ä–Η―¹―²–Η–Κ–Η –Ϋ–Α ―Ä–Β―΅―²–Α (–Ω―Ä–Ψ–Ζ–Ψ–¥–Η―è, –Β–Φ–Ψ―Ü–Η–Η, –Α–Κ―Ü–Β–Ϋ―²βÄΠ), ―¹–Ω–Β–Κ―²―Ä–Α–Μ–Ϋ–Α―²–Α ―Ö–Α―Ä–Α–Κ―²–Β―Ä–Η―¹―²–Η–Κ–Α –Ψ–Ω―Ä–Β–¥–Β–Μ―è, –Κ–Α–Κ–≤–Ψ ―²–Ψ―΅–Ϋ–Ψ –Β –±–Η–Μ–Ψ –Κ–Α–Ζ–Α–Ϋ–Ψ (–Ζ–Α –Η–Ζ–Κ–Μ―é―΅–Β–Ϋ–Η–Β –Ϋ–Α ―²–Ψ–Ϋ–Α–Μ–Ϋ–Η―²–Β –Β–Ζ–Η―Ü–Η, –Κ–Α―²–Ψ –Κ–Η―²–Α–Ι―¹–Κ–Η―è, –≤ –Κ–Ψ–Η―²–Ψ ―Ä–Α–Ζ–Μ–Η―΅–Ϋ–Η―²–Β –Ϋ–Η–≤–Α ―¹–Α –≤–Α–Ε–Ϋ–Η –Ζ–Α ―¹–Φ–Η―¹―ä–Μ–Α). –™–Μ–Α―¹–Ϋ–Η―²–Β –≤―Ä―ä–Ζ–Κ–Η –¥–Α–≤–Α―² –Ω―Ä–Η–±–Μ–Η–Ζ–Η―²–Β–Μ–Ϋ–Ψ –Β–¥–Ϋ–Α–Κ―ä–≤ –Ζ–≤―É–Κ –Ζ–Α –≤―¹―è–Κ–Α –≥–Μ–Α―¹–Ϋ–Α, –Α ―³–Ψ―Ä–Φ–Α―²–Α –Ϋ–Α –≥–Ψ–≤–Ψ―Ä–Ϋ–Η―è –Α–Ω–Α―Ä–Α―² –Ψ–Ω―Ä–Β–¥–Β–Μ―è –Κ–Α–Κ―ä–≤ –Ζ–≤―É–Κ ―â–Β –±―ä–¥–Β –Ω―Ä–Ψ–Η–Ζ–Ϋ–Β―¹–Β–Ϋ. –Δ–Ψ–≤–Α –Φ–Ψ–Ε–Β –Φ–Ϋ–Ψ–≥–Ψ –Β―³–Β–Κ―²–Η–≤–Ϋ–Ψ –¥–Α ―¹–Β –Ϋ–Α–Ω―Ä–Α–≤–Η, –Α–Κ–Ψ ―¹–Ω–Β–Κ―²―ä―Ä―ä―² ―¹–Β –Ω―Ä–Β–Ψ–±―Ä–Α–Ζ―É–≤–Α –≤ –Κ–Β–Ω―¹―²―ä―Ä. –î–Α –Ψ–±―ä―Ä–Ϋ–Β–Φ –≤–Ϋ–Η–Φ–Α–Ϋ–Η–Β –Ϋ–Α ―²–Ψ–Ζ–Η –Φ–Ψ–Φ–Β–Ϋ―².

–½–Α –≤―Ö–Ψ–¥–Β–Ϋ ―¹–Η–≥–Ϋ–Α–Μ ―¹ ―΅–Β―¹―²–Ψ―²–Α 16 KHz –Κ–Β–Ω―¹―²―ä―Ä―ä―² –Β –≤–Β–Κ―²–Ψ―Ä –Ψ―² 18 ―΅–Η―¹–Μ–Α –Ζ–Α –≤―¹–Β–Κ–Η 10 –Φ–Η–Μ–Η―¹–Β–Κ―É–Ϋ–¥–Η, –Κ–Ψ–Η―²–Ψ ―²―Ä―è–±–≤–Α –¥–Α ―¹–Β –Κ–Ψ–Φ–Ω―Ä–Β―¹–Η―Ä–Α―² –≤―ä–Ζ–Φ–Ψ–Ε–Ϋ–Ψ –Ϋ–Α–Ι-–Φ–Ϋ–Ψ–≥–Ψ. –ï–¥–Η–Ϋ –Ϋ–Α―à –Ω–Α–Κ–Β―² –Β ―¹ –≤―Ä–Β–Φ–Β―²―Ä–Α–Β–Ϋ–Β 40 ms βÄ™ ―²–Ψ–Β―¹―² ―²–Ψ–≤–Α ―¹–Α ―΅–Β―²–Η―Ä–Η –Ω–Ψ–¥–Ψ–±–Ϋ–Η –≤–Β–Κ―²–Ψ―Ä–Α, –Κ–Ψ–Η―²–Ψ –Ψ–±–Η–Κ–Ϋ–Ψ–≤–Β–Ϋ–Ψ ―¹–Η –Ω―Ä–Η–Μ–Η―΅–Α―², –Α –Ϋ–Η–Β –Η―¹–Κ–Α–Φ–Β –¥–Α –Ω―Ä–Β–Φ–Α―Ö–Ϋ–Β–Φ –Η–Ζ–Μ–Η―à―ä–Κ–Α. –Δ–Ψ–≤–Α –Φ–Ψ–Ε–Β –¥–Α ―¹―²–Α–Ϋ–Β ―΅―Ä–Β–Ζ –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Ϋ–Β –Ϋ–Α ―¹―ä―¹–Β–¥–Ϋ–Η―²–Β –≤–Β–Κ―²–Ψ―Ä–Η –Η –¥–Α –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Φ–Β ―¹–Α–Φ–Ψ ―Ä–Α–Ζ–Μ–Η–Κ–Α―²–Α –Φ–Β–Ε–¥―É –Ω―Ä–Β–¥―¹–Κ–Α–Ζ–Α–Ϋ–Ψ―²–Ψ –Η ―Ä–Β–Α–Μ–Ϋ–Ψ―²–Ψ –Ζ–Ϋ–Α―΅–Β–Ϋ–Η–Β. –£ ―¹―ä―â–Ψ―²–Ψ –≤―Ä–Β–Φ–Β, –Ϋ–Β –Η―¹–Κ–Α–Φ–Β –¥–Α –Ζ–Α–≤–Η―¹–Η–Φ –Ω―Ä–Β–Κ–Α–Μ–Β–Ϋ–Ψ –Φ–Ϋ–Ψ–≥–Ψ –Ψ―² –Ω―Ä–Β–¥–Η―à–Ϋ–Η―²–Β –Ω–Α–Κ–Β―²–Η, –Ω–Ψ–Ϋ–Β–Ε–Β –Α–Κ–Ψ –Ϋ―è–Κ–Ψ–Ι –Ψ―² ―²―è―Ö –±―ä–¥–Β –Η–Ζ–≥―É–±–Β–Ϋ, ―Ä–Β–Ζ―É–Μ―²–Α―²―ä―² –Ϋ–Β –Β –¥–Ψ–±―ä―Ä.

βÄû–ê–Κ–Ψ –Η–Φ–Α―²–Β ―¹–Α–Φ–Ψ ―΅―É–Κ, –≤―¹–Η―΅–Κ–Ψ –Ζ–Α–Ω–Ψ―΅–≤–Α –¥–Α –Η–Ζ–≥–Μ–Β–Ε–¥–Α –Κ–Α―²–Ψ –Ω–Η―Ä–Ψ–Ϋ–ΗβÄ€ βÄ™ –ê–±―Ä–Α―Ö–Α–Φ –€–Α―¹–Μ–Ψ―É

–ê–Κ–Ψ –Η–Φ–Α―²–Β –Ψ–Ω–Η―² ―¹ –≤–Η–¥–Β–Ψ –Κ–Ψ–¥–Β―Ü–Η―²–Β, –Ϋ–Α–≤―è―Ä–Ϋ–Ψ ―¹―²–Β ―¹–Β ―¹–±–Μ―ä―¹–Κ–Α–Μ–Η ―¹ –Ω–Ψ–Ϋ―è―²–Η–Β―²–Ψ –£-―³―Ä–Β–Ι–Φ. –ù–Ψ –Ζ–Α ―Ä–Α–Ζ–Μ–Η–Κ–Α –Ψ―² –≤–Η–¥–Β–Ψ –Κ–Ψ–¥–Β―Ü–Η―²–Β, –Κ–Ψ–Η―²–Ψ ―Ä–Α–Ζ–¥–Β–Μ―è―² –Κ–Α–¥―ä―Ä–Α –Ϋ–Α –Φ–Ϋ–Ψ–Ε–Β―¹―²–≤–Ψ –Ω–Α–Κ–Β―²–Η, –Ω―Ä–Η –Ϋ–Α―¹ –Β –Ψ–±―Ä–Α―²–Ϋ–Ψ―²–Ψ βÄ™ –Η–Φ–Α–Φ–Β –Φ–Ϋ–Ψ–≥–Ψ ―³―Ä–Β–Ι–Φ–Ψ–≤–Β –≤ –Β–¥–Η–Ϋ –Ω–Α–Κ–Β―². –½–Α–Ω–Ψ―΅–≤–Α–Φ–Β ―¹ –Κ–Ψ–¥–Η―Ä–Α–Ϋ–Β―²–Ψ –Ϋ–Α –Κ–Μ―é―΅–Ψ–≤–Η―è ―³―Ä–Β–Ι–Φ βÄ™ ―²–Ψ–Β―¹―², ―¹ –Ϋ–Β–Ζ–Α–≤–Η―¹–Η–Φ–Η―è –≤–Β–Κ―²–Ψ―Ä, –Κ–Α–Κ―²–Ψ –Η ―¹ –Κ―Ä–Α―è –Ϋ–Α –Ω–Α–Κ–Β―²–Α. –Δ–Ψ–Ζ–Η –≤–Β–Κ―²–Ψ―Ä ―¹–Β –Κ–Ψ–¥–Η―Ä–Α –±–Β–Ζ –Ω―Ä–Β–¥―¹–Κ–Α–Ζ–≤–Α–Ϋ–Β –Η –Ζ–Α–Β–Φ–Α 37 –±–Η―²–Α: 7 –Ζ–Α –Ω―ä―Ä–≤–Η―è –Κ–Β–Ω―¹―²―Ä–Α–Μ–Β–Ϋ –Κ–Ψ–Β―³–Η―Ü–Η–Β–Ϋ―² –Η –Ψ―â–Β 30 –±–Η―²–Α –Ζ–Α –Ζ–Α –Ψ―¹―²–Α–Ϋ–Α–Μ–Η―²–Β –Ω–Α―Ä–Α–Φ–Β―²―Ä–Η ―΅―Ä–Β–Ζ –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Ϋ–Β―²–Ψ –Ϋ–Α –≤–Β–Κ―²–Ψ―Ä–Ϋ–Ψ –Κ–≤–Α–Ϋ―²―É–≤–Α–Ϋ–Β (VQ). –Γ–Μ–Β–¥ ―²–Ψ–≤–Α –Η–¥–≤–Α―² –Ι–Β―Ä–Α―Ä―Ö–Η―΅–Ϋ–Η―²–Β –£-―³―Ä–Β–Ι–Φ–Ψ–≤–Β. –û―² –¥–≤–Α―²–Α –Κ–Μ―é―΅–Ψ–≤–Η –≤–Β–Κ―²–Ψ―Ä–Α (–Β–¥–Η–Ϋ–Η―è―² –Ψ―² ―²–Β–Κ―É―â–Η―è –Ω–Α–Κ–Β―², –Α –¥―Ä―É–≥–Η―è―² –Ψ―² –Ω―Ä–Β–¥–Η―à–Ϋ–Η―è) ―¹–Β –Ω―Ä–Ψ–≥–Ϋ–Ψ–Ζ–Η―Ä–Α –Κ–Β–Ω―¹―²―ä―Ä–Α –Φ–Β–Ε–¥―É ―²―è―Ö. –û―²–Ϋ–Ψ–≤–Ψ –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Φ–Β –≤–Β–Κ―²–Ψ―Ä–Ϋ–Ψ –Κ–≤–Α–Ϋ―²―É–≤–Α–Ϋ–Β –Η –Κ–Ψ–¥–Η―Ä–Α–Φ–Β –Ω–Ψ–Μ―É―΅–Β–Ϋ–Η―è –≤–Β–Κ―²–Ψ―Ä –≤ 13 –±–Η―²–Α. –ü–Ψ –Μ–Β―¹–Ϋ–Ψ –Β –¥–Α ―¹–Β ―Ä–Α–Ζ–±–Β―Ä–Β –Ψ―² ―¹–Μ–Β–¥–Ϋ–Ψ―²–Ψ –Η–Ζ–Ψ–±―Ä–Α–Ε–Β–Ϋ–Η–Β:

–Γ–≥–Μ–Ψ–±―è–≤–Α–Φ–Β –≤―¹–Η―΅–Κ–Ψ –Ϋ–Α –Β–¥–Ϋ–Ψ –Φ―è―¹―²–Ψ

–ö–Ψ–≥–Α―²–Ψ ―¹―ä–±–Β―Ä–Β–Φ –≤―¹–Η―΅–Κ–Ψ –Η–Ζ–±―Ä–Ψ–Β–Ϋ–Ψ –¥–Ψ―²―É–Κ, –Ω–Ψ–Μ―É―΅–Α–≤–Α–Φ–Β 64 –±–Η―²–Α –Ϋ–Α –Β–¥–Η–Ϋ 40 ms –Ω–Α–Κ–Β―² –Η–Μ–Η 1600 –±–Η―²–Α –≤ ―¹–Β–Κ―É–Ϋ–¥–Α. –î–Α –Ω―Ä–Β―¹–Φ–Β―²–Ϋ–Β–Φ –Κ–Ψ–Β―³–Η―Ü–Η–Β–Ϋ―²–Α –Ϋ–Α –Κ–Ψ–Φ–Ω―Ä–Β―¹–Η―è―²–Α. –®–Η―Ä–Ψ–Κ–Ψ–Μ–Β–Ϋ―²–Ψ–≤–Α―²–Α ―΅–Ψ–≤–Β―à–Κ–Α ―Ä–Β―΅ –±–Β–Ζ –Κ–Ψ–Φ–Ω―Ä–Β―¹–Η―è –Β ―¹ –±–Η―²―Ä–Β–Ι―² –Ψ–Κ–Ψ–Μ–Ψ 256 Kb/s (16 KHz –Ω–Ψ 16 –±–Η―²–Α –Ϋ–Α ―¹–Β–Φ–Ω―ä–Μ). –ê ―²–Ψ–≤–Α –Ψ–Ζ–Ϋ–Α―΅–Α–≤–Α –Κ–Ψ–Φ–Ω―Ä–Β―¹–Η―è –Ψ―² 160 –Ω―ä―²–Η! –†–Α–Ζ–±–Η―Ä–Α ―¹–Β, –Φ–Ψ–≥–Α―² –¥–Α ―¹–Β –Ω―Ä–Ψ–Φ–Β–Ϋ―è―² –Ω–Α―Ä–Α–Φ–Β―²―Ä–Η―²–Β –Ϋ–Α –Κ–≤–Α–Ϋ―²―É–≤–Α–Ϋ–Β―²–Ψ –Η –¥–Α ―¹–Β –Ω–Ψ–Μ―É―΅–Η –Ω–Ψ-–≤–Η―¹–Ψ–Κ –Η–Μ–Η –Ω–Ψ-–Ϋ–Η―¹―ä–Κ –±–Η―²―Ä–Β–Ι―², –Ω―Ä–Η –Κ–Ψ–Β―²–Ψ ―¹–Β –Ω–Ψ–Μ―É―΅–Α–≤–Α –Ω–Ψ-–≤–Η―¹–Ψ–Κ–Ψ –Η–Μ–Η –Ω–Ψ-–Ϋ–Η―¹–Κ–Ψ –Κ–Α―΅–Β―¹―²–≤–Ψ –Ϋ–Α ―Ä–Β―΅―²–Α. –ï―²–Ψ –Η ―²–Α–±–Μ–Η―Ü–Α―²–Α, –Ω–Ψ–Κ–Α–Ζ–≤–Α―â–Α –Ζ–Α –Κ–Α–Κ–≤–Ψ ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α―² –±–Η―²–Ψ–≤–Β―²–Β:

–ü–Ψ 64 –±–Η―²–Α –Ϋ–Α 40 ms –Ω–Α–Κ–Β―²: –Ω―Ä–Η 25 –Ω–Α–Κ–Β―²–Α –≤ ―¹–Β–Κ―É–Ϋ–¥–Α –Ω–Ψ–Μ―É―΅–Α–≤–Α–Φ–Β 1600 –±–Η―²–Α –≤ ―¹–Β–Κ―É–Ϋ–¥–Α.

–†–Β–Α–Μ–Η–Ζ–Α―Ü–Η―è―²–Α

–Γ–Ψ―Ä―¹ –Κ–Ψ–¥―ä―² –Ϋ–Α LPCNet ―¹–Β –Ω―Ä–Β–¥–Μ–Α–≥–Α –Ω–Ψ–¥ BSD –Μ–Η―Ü–Β–Ϋ–Ζ–Α. –£–Κ–Μ―é―΅–Β–Ϋ–Α –Β –Η –±–Η–±–Μ–Η–Ψ―²–Β–Κ–Α―²–Α, –Κ–Ψ―è―²–Ψ –Ψ–Ω―Ä–Ψ―¹―²―è–≤–Α –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Ϋ–Β―²–Ψ –Ϋ–Α –Κ–Ψ–¥–Β–Κ–Α. –û–±―ä―Ä–Ϋ–Β―²–Β –≤–Ϋ–Η–Φ–Α–Ϋ–Η–Β, ―΅–Β –Ω―Ä–Ψ–Β–Κ―²―ä―² –Ϋ–Β –Β –Ω―Ä–Η–Κ–Μ―é―΅–Β–Ϋ: –Η ―³–Ψ―Ä–Φ–Α―²―ä―² –Η API –Ζ–Α–¥―ä–Μ–Ε–Η―²–Β–Μ–Ϋ–Ψ ―â–Β –±―ä–¥–Α―² –Ω―Ä–Ψ–Φ–Β–Ϋ–Β–Ϋ–Η. –£ ―Ö―Ä–Α–Ϋ–Η–Μ–Η―â–Β―²–Ψ –Β –Κ–Α―΅–Β–Ϋ–Ψ –¥–Β–Φ–Ψ–Ϋ―¹―²―Ä–Α―Ü–Η–Ψ–Ϋ–Ϋ–Ψ―²–Ψ –Ω―Ä–Η–Μ–Ψ–Ε–Β–Ϋ–Η–Β lpcnet_demo, ―¹ –Ω–Ψ–Φ–Ψ―â―²–Α –Ϋ–Α –Κ–Ψ–Β―²–Ψ –Κ–Ψ–¥–Β–Κ―ä―² –Μ–Β―¹–Ϋ–Ψ –Φ–Ψ–Ε–Β –¥–Α ―¹–Β ―²–Β―¹―²–≤–Α –Ψ―² –Κ–Ψ–Φ–Α–Ϋ–¥–Ϋ–Η―è ―Ä–Β–¥.

–ü―Ä–Ψ–Η–Ζ–≤–Ψ–¥–Η―²–Β–Μ–Ϋ–Ψ―¹―²

–ù–Β–≤―Ä–Ψ–Ϋ–Ϋ–Η―è―² ―¹–Η–Ϋ―²–Β–Ζ –Ϋ–Α ―Ä–Β―΅―²–Α –Η–Ζ–Η―¹–Κ–≤–Α –Φ–Ϋ–Ψ–≥–Ψ ―Ä–Β―¹―É―Ä―¹–Η. –ù–Α –Φ–Η–Ϋ–Α–Μ–Ψ–≥–Ψ–¥–Η―à–Ϋ–Α―²–Α –Κ–Ψ–Ϋ―³–Β―Ä–Β–Ϋ―Ü–Η―è ICASSP –ë–Α―¹―²–Η–Α–Ϋ –ö–Β–Ι ―¹ –Κ–Ψ–Μ–Β–≥–Η―²–Β ―¹–Η –Ψ―² Google/DeepMind –Ω―Ä–Β–¥―¹―²–Α–≤–Η―Ö–Α –Κ–Ψ–¥–Β–Κ ―¹ 2400 –±–Η―²–Α –≤ ―¹–Β–Κ―É–Ϋ–¥–Α –Ϋ–Α –±–Α–Ζ–Α―²–Α –Ϋ–Α WaveNet. –†–Β―΅―²–Α –Ϋ–Α ―²–Α–Ζ–Η ―¹–Η―¹―²–Β–Φ–Α –Ζ–≤―É―΅–Η –Ω–Ψ―²―Ä–Β―¹–Α–≤–Α―â–Ψ, –Ϋ–Ψ –Η–Ζ―΅–Η―¹–Μ–Η―²–Β–Μ–Ϋ–Α―²–Α ―¹–Μ–Ψ–Ε–Ϋ–Ψ―¹―² –Ψ―² ―¹―²–Ψ―²–Η―Ü–Η –≥–Η–≥–Α―³–Μ–Ψ–Ω―¹–Η –Ψ–Ζ–Ϋ–Α―΅–Α–≤–Α, ―΅–Β ―²–Α–Ζ–Η ―¹–Η―¹―²–Β–Φ–Α –Ϋ―è–Φ–Α –Κ–Α–Κ –¥–Α ―Ä–Α–±–Ψ―²–Η –≤ ―Ä–Β–Α–Μ–Ϋ–Ψ –≤―Ä–Β–Φ–Β –±–Β–Ζ ―¹–Κ―ä–Ω–Η –≥―Ä–Α―³–Η―΅–Ϋ–Η ―É―¹–Κ–Ψ―Ä–Η―²–Β–Μ–Η –Η ―¹–Β―Ä–Η–Ψ–Ζ–Ϋ–Η ―É―¹–Η–Μ–Η―è.

–ù–Α–Ω―Ä–Ψ―²–Η–≤, –Ϋ–Α―à–Η―è―² 1600 bit/s –Κ–Ψ–¥–Β–Κ –Η–Φ–Α –Ϋ―É–Ε–¥–Α ―¹–Α–Φ–Ψ –Ψ―² 3 –≥–Η–≥–Α―³–Μ–Ψ–Ω―¹–Α –Η –Β ―¹–Ω–Β―Ü–Η–Α–Μ–Ϋ–Ψ –Ω―Ä–Β–¥–Ϋ–Α–Ζ–Ϋ–Α―΅–Β–Ϋ –¥–Α ―Ä–Α–±–Ψ―²–Η –≤ ―Ä–Β–Α–Μ–Ϋ–Ψ –≤―Ä–Β–Φ–Β –Ϋ–Α –¥–Ψ―¹―²―ä–Ω–Β–Ϋ ―Ö–Α―Ä–¥―É–Β―Ä. –ù–Α –Ω―Ä–Α–Κ―²–Η–Κ–Α, ―²–Ψ–Ι –Φ–Ψ–Ε–Β –Ψ―â–Β –¥–Ϋ–Β―¹ –¥–Α ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α –≤ ―Ä–Β–Α–Μ–Ϋ–Η –Ω―Ä–Η–Μ–Ψ–Ε–Β–Ϋ–Η―è. –ü―Ä–Η –Ψ–Ω―²–Η–Φ–Η–Ζ–Α―Ü–Η―è―²–Α ―¹–Β –Ϋ–Α–Μ–Ψ–Ε–Η –¥–Α ―¹–Β –Ϋ–Α–Ω–Η―à–Β –Φ–Α–Μ–Κ–Ψ –Κ–Ψ–¥ ―¹ –Η–Ϋ―¹―²―Ä―É–Κ―Ü–Η–Η―²–Β AVX2/FMA –Η Neon (―¹–Α–Φ–Ψ –≤–≥―Ä–Α–¥–Β–Ϋ –Κ–Ψ–¥ –±–Β–Ζ –Α―¹–Β–Φ–±–Μ–Β―Ä). –ë–Μ–Α–≥–Ψ–¥–Α―Ä–Β–Ϋ–Η–Β –Ϋ–Α ―²–Ψ–Ζ–Η –Ω–Ψ–¥―Ö–Ψ–¥ ―¹–Β–≥–Α –Φ–Ψ–Ε–Β–Φ –¥–Α –Κ–Ψ–¥–Η―Ä–Α–Φ–Β –Η –Ψ―¹–Ψ–±–Β–Ϋ–Ψ –¥–Α –¥–Β–Κ–Ψ–¥–Η―Ä–Α–Φ–Β ―΅–Ψ–≤–Β―à–Κ–Α ―Ä–Β―΅ –≤ ―Ä–Β–Ε–Η–Φ –Ϋ–Α ―Ä–Β–Α–Μ–Ϋ–Ψ –≤―Ä–Β–Φ–Β –Ϋ–Β ―¹–Α–Φ–Ψ –≤ –Ω–Β―Ä―¹–Ψ–Ϋ–Α–Μ–Ϋ–Η―²–Β –Κ–Ψ–Φ–Ω―é―²―Ä–Η, –Ϋ–Ψ –Η –≤ –Ω–Ψ-―¹―ä–≤―Ä–Β–Φ–Β–Ϋ–Ϋ–Η―²–Β ―¹–Φ–Α―Ä―²―³–Ψ–Ϋ–Η. –ü–Ψ-–¥–Ψ–Μ―É –Β –Ω–Ψ–Κ–Α–Ζ–Α–Ϋ–Α –Ω―Ä–Ψ–Η–Ζ–≤–Ψ–¥–Η―²–Β–Μ–Ϋ–Ψ―¹―²―²–Α –Ω―Ä–Η –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Ϋ–Β―²–Ψ –Ϋ–Α x86 –Η ARM –Ω―Ä–Ψ―Ü–Β―¹–Ψ―Ä–Η.

–Π–Η―³―Ä–Η―²–Β ―¹–Α –¥–Ψ―¹―²–Α –Η–Ϋ―²–Β―Ä–Β―¹–Ϋ–Η. –£―ä–Ω―Ä–Β–Κ–Η ―΅–Β ―¹–Α –Ω–Ψ–Κ–Α–Ζ–Α–Ϋ–Η ―¹–Α–Φ–Ψ Broadwell –Η Threadripper, –Ω―Ä–Η x86 –Ω–Μ–Α―²―³–Ψ―Ä–Φ–Α―²–Α –Ω―Ä–Ψ―Ü–Β―¹–Ψ―Ä–Η―²–Β Haswell –Η Skylake –¥–Β–Φ–Ψ–Ϋ―¹―²―Ä–Η―Ä–Α―² ―¹―Ö–Ψ–¥–Ϋ–Α –Ω―Ä–Ψ–Η–Ζ–≤–Ψ–¥–Η―²–Β–Μ–Ϋ–Ψ―¹―². –ù–Ψ ―Ä–Β–Ζ―É–Μ―²–Α―²–Η―²–Β –Ϋ–Α ARM –Ω―Ä–Ψ―Ü–Β―¹–Ψ―Ä–Η―²–Β –Ζ–Ϋ–Α―΅–Η―²–Β–Μ–Ϋ–Ψ ―¹–Β ―Ä–Α–Ζ–Μ–Η―΅–Α–≤–Α―². –î–Ψ―Ä–Η –Κ–Α―²–Ψ ―¹–Β –Ψ―²―΅–Β―²–Β ―Ä–Α–Ζ–Μ–Η–Κ–Α―²–Α –≤ ―΅–Β―¹―²–Ψ―²–Η―²–Β, A76 ―è–¥―Ä–Ψ―²–Ψ –Β –Ω–Β―²-―à–Β―¹―² –Ω―ä―²–Η –Ω–Ψ-–±―ä―Ä–Ζ–Ψ –Ψ―² A53. –Δ–Ψ–≤–Α –Β ―Ä–Α–Ζ–±–Η―Ä–Α–Β–Φ–Ψ, –Ω–Ψ–Ϋ–Β–Ε–Β A53 ―è–¥―Ä–Ψ―²–Ψ ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α –Ω―Ä–Β–¥–Η–Φ–Ϋ–Ψ –Ζ–Α –Ω–Ψ-–≤–Η―¹–Ψ–Κ–Α –Β–Ϋ–Β―Ä–≥–Η–Ι–Ϋ–Α –Β―³–Β–Κ―²–Η–≤–Ϋ–Ψ―¹―² –≤ big.LITTLE –Ω―Ä–Ψ―Ü–Β―¹–Ψ―Ä–Η―²–Β. –ù–Ψ LPCNet ―¹―ä–≤―¹–Β–Φ –Β―³–Β–Κ―²–Η–≤–Ϋ–Ψ ―Ä–Α–±–Ψ―²–Η –≤ ―Ä–Β–Ε–Η–Φ –Ϋ–Α ―Ä–Β–Α–Μ–Ϋ–Ψ –≤―Ä–Β–Φ–Β –≤ –Ω–Ψ-―¹―ä–≤―Ä–Β–Φ–Β–Ϋ–Ϋ–Η―²–Β ―²–Β–Μ–Β―³–Ψ–Ϋ–Η, –Κ–Α―²–Ψ –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α ―¹–Α–Φ–Ψ –Β–¥–Ϋ–Ψ ―è–¥―Ä–Ψ. –û–±–Φ–Η―¹–Μ―è–Φ–Β –¥–Α –Ϋ–Α–Ω―Ä–Α–≤–Η–Φ –¥–Ω–Β―Ü–Η–Α–Μ–Ϋ–Α –≤–Β―Ä―¹–Η―è –Η –Ζ–Α Raspberry Pi 3.

x86 –Ω―Ä–Ψ―Ü–Β―¹–Ψ―Ä–Η―²–Β ―¹–Η –Ψ―¹―²–Α–Ϋ–Α―Ö–Α –Ζ–Α–≥–Α–¥–Κ–Α –Η –Ϋ–Β –Φ–Ψ–Ε–Α―Ö–Φ–Β –¥–Α ―Ä–Α–Ζ–±–Β―Ä–Β–Φ, –Ζ–Α―â–Ψ –¥–Β–Φ–Ψ–Ϋ―¹―²―Ä–Η―Ä–Α―² ―²–Ψ–Κ–Ψ–≤–Α –Ψ–≥―Ä–Α–Ϋ–Η―΅–Β–Ϋ–Α –Ω―Ä–Ψ–Η–Ζ–≤–Ψ–¥–Η―²–Β–Μ–Ϋ–Ψ―¹―² βÄ™ ―Ü–Β–Μ–Η 5 –Ω―ä―²–Η –Ω–Ψ-–Ϋ–Η―¹–Κ–Α –Ψ―² ―²–Β–Ψ―Ä–Β―²–Η―΅–Ϋ–Η―è –Φ–Α–Κ―¹–Η–Φ―É–Φ. –‰–Ζ–≤–Β―¹―²–Ϋ–Ψ –Β, ―΅–Β ―É–Φ–Ϋ–Ψ–Ε–Β–Ϋ–Η–Β―²–Ψ –Ϋ–Α –Φ–Α―²―Ä–Η―Ü–Α ―¹ –≤–Β–Κ―²–Ψ―Ä –Β –Ω–Ψ-–Φ–Α–Μ–Κ–Ψ –Β―³–Β–Κ―²–Η–≤–Ϋ–Ψ –Ψ―²–Κ–Ψ–Μ–Κ–Ψ―²–Ψ –Ϋ–Α –Φ–Α―²―Ä–Η―Ü–Α ―¹ –Φ–Α―²―Ä–Η―Ü–Α, –Ω–Ψ–Ϋ–Β–Ε–Β –Η–Φ–Α –Ω–Ψ–≤–Β―΅–Β –Ψ–±―Ä―ä―â–Β–Ϋ–Η―è –Κ―ä–Φ –Ψ–Ω–Β―Ä–Α―²–Η–≤–Ϋ–Α―²–Α –Ω–Α–Φ–Β―². –û―² –Β–¥–Ϋ–Α ―¹―²―Ä–Α–Ϋ–Α, –Ω―Ä–Ψ–Η–Ζ–≤–Ψ–¥–Η―²–Β–Μ–Ϋ–Ψ―¹―²―²–Α –Β ―¹–≤―ä―Ä–Ζ–Α–Ϋ–Α ―¹ L2 –Κ–Β―à–Α, –Κ–Ψ–Ι―²–Ψ –Ω―Ä–Β–¥–Ψ―¹―²–Α–≤―è ―¹–Α–Φ–Ψ 16 –±–Η―²–Α –Ϋ–Α ―Ü–Η–Κ―ä–Μ. –ù–Ψ –Ψ―² –¥―Ä―É–≥–Α ―¹―²―Ä–Α–Ϋ–Α Intel ―²–≤―ä―Ä–¥–Η, ―΅–Β L2 –Κ–Β―à―ä―² –Φ–Ψ–Ε–Β –¥–Α –¥–Α–¥–Β –¥–Ψ 32 –±–Η―²–Α –Ϋ–Α ―Ü–Η–Κ―ä–Μ –Ω―Ä–Η Broadwell –Η 64 –±–Η―²–Α –Ϋ–Α ―Ü–Η–Κ―ä–Μ –Ω―Ä–Η Skylake.

–ß―É–Ι―²–Β ―¹–Α–Φ–Η:

–•–Β–Ϋ–Α:

- –û―Ä–Η–≥–Η–Ϋ–Α–Μ

- LPCNet 1600 bit/s

- –ù–Β–Κ–Ψ–Φ–Ω―Ä–Β―¹–Η―Ä–Α–Ϋ LPNet

- Opus 9000 bit/s

- MELP 2400 bit/s

- Speex 4000 bit/s

–€―ä–Ε

- –û―Ä–Η–≥–Η–Ϋ–Α–Μ

- LPCNet 1600 bit/s

- –ù–Β–Κ–Ψ–Φ–Ω―Ä–Β―¹–Η―Ä–Α–Ϋ LPNet

- Opus 9000 bit/s

- MELP 2400 bit/s

- Speex 4000 bit/s

–ö―ä–¥–Β –±–Η –Φ–Ψ–≥―ä–Μ –¥–Α ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α LPNet?

–ù–Η–Β ―¹―΅–Η―²–Α–Φ–Β, ―΅–Β ―²–Ψ–≤–Α –Β –Β–¥–Ϋ–Α –Ω–Β―Ä―³–Β–Κ―²–Ϋ–Α ―²–Β―Ö–Ϋ–Ψ–Μ–Ψ–≥–Η―è, –Κ–Ψ–Η―²–Ψ –Φ–Ψ–Ε–Β –¥–Α –±―ä–¥–Β ―à–Η―Ä–Ψ–Κ–Ψ –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Ϋ–Α. –ï―²–Ψ –Ϋ―è–Κ–Ψ–Η –≤–Α―Ä–Η–Α–Ϋ―²–Η:

VoIP –≤ –¥―ä―Ä–Ε–Α–≤–Η ―¹ –Μ–Ψ―à–Α –Η–Ϋ―²–Β―Ä–Ϋ–Β―² –≤―Ä―ä–Ζ–Κ–Α

–ù–Β –≤―¹–Η―΅–Κ–Η –Η–Φ–Α―² –Ω–Ψ 24 ―΅–Α―¹–Α –≤ –¥–Β–Ϋ–Ψ–Ϋ–Ψ―â–Η–Β―²–Ψ –≤–Η―¹–Ψ–Κ–Ψ―¹–Κ–Ψ―Ä–Ψ―¹―²–Ϋ–Α –≤―Ä―ä–Ζ–Κ–Α. –ù–Ψ–≤–Η―è―² 1600 bit/s –Κ–Ψ–¥–Β–Κ –Ϋ–Α ―΅–Ψ–≤–Β―à–Κ–Α―²–Α ―Ä–Β―΅ –Ϋ–Ψ―Ä–Φ–Α–Μ–Ϋ–Ψ ―Ä–Α–±–Ψ―²–Η –≤ –Ω–Ψ–¥–Ψ–±–Ϋ–Η ―É―¹–Μ–Ψ–≤–Η―è –Η –¥–Ψ―Ä–Η ―É―¹–Ω―è–≤–Α –¥–Α –≤–Φ―ä–Κ–Ϋ–Β –¥–Ψ–Ω―ä–Μ–Ϋ–Η―²–Β–Μ–Ϋ–Η –Ω–Α–Κ–Β―²–Η –Ζ–Α –Ω–Ψ-–≤–Η―¹–Ψ–Κ–Α –Ϋ–Α–¥–Β–Ε–¥–Ϋ–Ψ―¹―² –Η –Ω–Ψ-–¥–Ψ–±―Ä–Ψ –Κ–Α―΅–Β―¹―²–≤–Ψ. –£ ―²–Ψ–Ζ–Η ―¹–Μ―É―΅–Α–Ι –Β –Ω–Ψ-–¥–Ψ–±―Ä–Β –¥–Α ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α―² –Ω–Ψ-–¥―ä–Μ–≥–Η –Ω–Α–Κ–Β―²–Η βÄ™ 40, 80 –Η–Μ–Η 120 –Φ–Η–Μ–Η―¹–Β–Κ―É–Ϋ–¥–Η.

–¦―é–±–Η―²–Β–Μ―¹–Κ–Ψ HF ―Ä–Α–¥–Η–Ψ

–û―² –¥–Β―¹–Β―² –≥–Ψ–¥–Η–Ϋ–Η –¥–Ψ–±―Ä–Β –Η–Ζ–≤–Β―¹―²–Ϋ–Η―è―² –î–Β–Ι–≤–Η–¥ –†–Ψ―É ―Ä–Α–±–Ψ―²–Η –≤―ä―Ä―Ö―É –Κ–Ψ–¥–Η―Ä–Α–Ϋ–Β―²–Ψ –Ϋ–Α ―Ä–Β―΅―²–Α, –Κ–Ψ–Β―²–Ψ –¥–Α ―¹–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α –≤ ―Ä–Α–¥–Η–Ψ–≤―Ä―ä–Ζ–Κ–Η―²–Β. –Δ–Ψ–Ι ―Ä–Α–Ζ―Ä–Α–±–Ψ―²–Η –Κ–Ψ–¥–Β–Κ–Α Codec2, –Κ–Ψ–Ι―²–Ψ –Ω―Ä–Β–¥–Α–≤–Α –≥–Μ–Α―¹ ―¹―ä―¹ ―¹–Κ–Ψ―Ä–Ψ―¹―² –Ψ―² 700 –¥–Ψ 3200 bit/s. –€–Η–Ϋ–Α–Μ–Α―²–Α –≥–Ψ–¥–Η–Ϋ–Α –Ψ–±―¹―ä–¥–Η―Ö–Φ–Β ―¹ –Ϋ–Β–≥–Ψ –Ω–Ψ–¥–Ψ–±―Ä―è–≤–Α–Ϋ–Β―²–Ψ –Ϋ–Α Codec2 ―¹ –Ω–Ψ–Φ–Ψ―â―²–Α –Ϋ–Α –Ϋ–Β–≤―Ä–Ψ–Ϋ–Β–Ϋ –Α–Ϋ–Α–Μ–Η–Ζ –Η ―²–Α–Ζ–Η –≥–Ψ–¥–Η–Ϋ–Α –Ϋ–Α–Ω―Ä–Α–≤–Η―Ö–Φ–Β ―²–Ψ–≤–Α. –î–Β–Ι–≤–Η–¥ –Ψ–Ω–Η―¹–Α –≤ ―¹–≤–Ψ―è –±–Μ–Ψ–≥ ―¹–Ψ–±―¹―²–≤–Β–Ϋ–Α―²–Α ―¹–Η ―Ä–Β–Α–Μ–Η–Ζ–Α―Ü–Η―è –Ϋ–Α –Ϋ–Ψ–≤ –Κ–Ψ–¥–Β–Κ –Ϋ–Α –±–Α–Ζ–Α―²–Α –Ϋ–Α LPCNet, –Η–Ϋ―²–Β–≥―Ä–Η―Ä–Α–Ϋ ―¹ FreeDV.

–ë―ä–¥–Β―â–Η –Ω–Μ–Α–Ϋ–Ψ–≤–Β

–ü―Ä–Β–¥―¹―²–Ψ–Η –Ϋ–Η –¥–Α –Ω―Ä–Η–Μ–Ψ–Ε–Η–Φ LPCNet –≤ –Ψ―â–Β –Φ–Ϋ–Ψ–≥–Ψ –Ψ–±–Μ–Α―¹―²–Η. –Δ–Α–Κ–Α –Ϋ–Α–Ω―Ä–Η–Φ–Β―Ä, –≤―ä–Ζ–Φ–Ψ–Ε–Ϋ–Ψ –Β –Ζ–Ϋ–Α―΅–Η―²–Β–Μ–Ϋ–Ψ –Ω–Ψ–¥–Ψ–±―Ä–Β–Ϋ–Η–Β –≤ ―Ä–Α–±–Ψ―²–Α―²–Α –Ϋ–Α ―¹–Β–≥–Α ―¹―ä―â–Β―¹―²–≤―É–≤–Α―â–Η―²–Β –Κ–Ψ–¥–Β―Ü–Η. –ö–Α–Κ―²–Ψ –Η –≤―¹–Η―΅–Κ–Η –¥―Ä―É–≥–Η –Κ–Ψ–¥–Β―Ü–Η, Opus –±―ä―Ä–Ζ–Ψ –¥–Β–≥―Ä–Α–¥–Η―Ä–Α –Ω―Ä–Η –Φ–Ϋ–Ψ–≥–Ψ –Ϋ–Η―¹―ä–Κ –±–Η―²―Ä–Β–Ι―² (–Ω–Ψ–¥ 8000 bit/s). –ù–Ψ –Ϋ–Α―à–Η―è―² –Α–Μ–≥–Ψ―Ä–Η―²―ä–Φ –Ζ–Α –Μ–Η–Ϋ–Β–Ι–Ϋ–Ψ –Ω―Ä–Β–¥―¹–Κ–Α–Ζ–≤–Α–Ϋ–Β –Β –¥–Ψ―¹―²–Α―²―ä―΅–Β–Ϋ –Ϋ–Α LPCNet, –Ζ–Α –¥–Α ―¹–Η–Ϋ―²–Β–Ζ–Η―Ä–Α –Ϋ–Ψ―Ä–Φ–Α–Μ–Ϋ–Ψ –Ζ–≤―É―΅–Α―â–Α ―΅–Ψ–≤–Β―à–Κ–Α ―Ä–Β―΅ βÄ™ –Φ–Ϋ–Ψ–≥–Ψ –Ω–Ψ-–¥–Ψ–±―Ä–Β –Ψ―²–Κ–Ψ–Μ–Κ–Ψ―²–Ψ Opus –Φ–Ψ–Ε–Β –¥–Α –Ϋ–Α–Ω―Ä–Α–≤–Η –Ω―Ä–Η –Ω–Ψ–¥–Ψ–±–Β–Ϋ –±–Η―²―Ä–Β–Ι―². –û―² –¥―Ä―É–≥–Α ―¹―²―Ä–Α–Ϋ–Α, –Ω―Ä–Ψ–≥–Ϋ–Ψ–Ζ–Ϋ–Η―²–Β –Α–Μ–≥–Ψ―Ä–Η―²–Φ–Η –Ϋ–Α Opus –Ω–Ψ–Φ–Α–≥–Α―² –Ϋ–Α LPCNet –¥–Α ―¹–Η–Ϋ―²–Β–Ζ–Η―Ä–Α –Ψ―â–Β –Ω–Ψ-–¥–Ψ–±―ä―Ä ―Ä–Β–Ζ―É–Μ―²–Α―² –Η ―²―è―Ö–Ϋ–Α―²–Α ―¹―ä–≤–Φ–Β―¹―²–Ϋ–Α ―Ä–Α–±–Ψ―²–Α –Β –Φ–Ϋ–Ψ–≥–Ψ ―É–¥–Α―΅–Ϋ–Α. –ü–Ψ–¥–Ψ–±–Β–Ϋ –Ω–Ψ–¥―Ö–Ψ–¥ –Φ–Ψ–Ε–Β –¥–Α ―¹–Β –Ω―Ä–Η–Μ–Ψ–Ε–Η –Η –Ω―Ä–Η ―Ä–Β–¥–Η―Ü–Α –¥―Ä―É–≥–Η –Κ–Ψ–¥–Β―Ü–Η.

–ü―Ä–Ψ―΅–Β―²–Β―²–Β –Ψ―â–Β

- 10:00 –•–Η–≤–Η―²–Β –Φ―ä―Ä―²–≤–Η - –≤ –¥–Α–¥–Β–Ϋ –Φ–Ψ–Φ–Β–Ϋ―² –Φ–Ψ–Ε–Β –≤–Η–Β –¥–Α ―¹―²–Β –≤ –≥–Μ–Α–≤–Ϋ–Η―²–Β ―Ä–Ψ–Μ–Η

- 10:49 –Δ―Ä–Α–≥–Β–¥–Η―è! –€–Μ–Α–¥ –Φ―ä–Ε ―¹–Β –Ψ–±―ä―Ä–Ϋ–Α ―¹ –Κ–Ψ–Μ–Α―²–Α ―¹–Η –Ϋ–Α "–Δ―Ä–Α–Κ–Η―è", –Ζ–Α–≥–Η–Ϋ–Α* –Γ–ù–‰–€–ö–ê

- 08:00 –ö–Ψ–≥–Α –Β –Ω–Ψ-–¥–Ψ–±―Ä–Β –¥–Α ―¹–Β –Ω–Η–Β –Κ–Α―³–Β - –Ω―Ä–Β–¥–Η –Η–Μ–Η ―¹–Μ–Β–¥ ―Ö―Ä–Α–Ϋ–Β–Ϋ–Β

- 23:00 –î–Ϋ–Β–≤–Β–Ϋ ―Ö–Ψ―Ä–Ψ―¹–Κ–Ψ–Ω –Ζ–Α 18 –Φ–Α–Ι: –Δ–Β–Μ―Ü–Η, –Η–Ζ–±―è–≥–≤–Α–Ι―²–Β –Ϋ–Β―É–¥–Ψ–±–Ϋ–Η―²–Β ―¹–Η―²―É–Α―Ü–Η–Η!